一、行业背景:AI算力需求变革催生新架构机遇

随着 AI 技术从「暴力堆算力」的 ChatGPT 时代迈入「效率优先」的 DeepSeek 新阶段,行业竞争焦点逐渐转向算力成本优化与资源利用率提升。以 DeepSeek 等为代表的高效模型通过算法创新(稀疏化、量化)显著降低算力需求,但多模态、实时推理等场景对数据吞吐效率和内存灵活性的要求不降反升。传统计算架构面临三大瓶颈:

内存墙:GPU/加速器与 CPU 间数据搬运延迟高,HBM 成本居高不下;

资源孤岛:计算、存储、网络设备分立,利用率不足;

扩展性限制:单机内存容量受限,分布式训练通信开销大。

在此背景下,CXL(Compute Express Link)作为一种颠覆性互联协议,凭借其内存池化、缓存一致性和低延迟特性,成为突破上述瓶颈的关键技术,其商业化进程已进入爆发前夜。

二、CXL技术优势:重构算力基础设施的「神经中枢」

CXL 技术是一种高速互联技术,旨在改善计算系统内部各个组件之间的通信效率。它提供了一种高带宽、低延迟的通信通道,使内存、加速器和其他计算资源能够直接连接,从而大幅提升了数据传输速度和系统整体性能。

CXL 技术的出现为计算密集型任务和数据密集型应用带来了巨大的潜力,并为下一代数据中心架构的构建提供了新的思路。CXL 技术的设计目标是提供一种通用的高速互连接口,可以与不同类型的计算加速器和设备进行连接。它基于 PCI Express(PCIe)物理层和协议,但在协议层面进行了扩展和优化,以满足高性能计算和数据中心应用的需求。

1. 内存资源革命:从「独占」到「共享」

(1)内存池化(Memory Pooling):CXL 支持跨 CPU、GPU、FPGA 等设备的内存统一编址,可将分散的内存聚合为共享池,动态分配给不同任务。例如,训练任务可「借用」空闲推理服务器的内存,降低硬件的冗余投资。

(2)弹性扩展:通过 CXL 连接的内存扩展卡,单服务器内存容量可从 TB 级提升至 PB 级,突破大模型训练的内存限制,同时减少采购高价 HBM。这不仅可以提高系统的可扩展性,还能降低总体拥有成本(TCO)。

2. 打破「数据搬运墙」

(1)缓存一致性协议:CXL 允许 CPU 与加速器直接共享缓存,减少数据复制次数,显著降低 AI 推理延迟。这对于需要快速响应的应用场景尤为重要,如自动驾驶和实时数据分析。

(2)带宽及组网优势:CXL 3.0 版本提供高达 64GT/s 的传输速率,是 PCIe 5.0 的 2 倍,且支持多层级联,非常适合 AI 集群的横向扩展。这种高效的组网能力使得大规模并行计算成为可能,提升了整体计算效率。

3. 显著降本增效

利用 CXL 内存扩展显然会对资本支出产生巨大影响。业内普遍认为,对于超大规模数据中心而言,内存成本占总资本支出的约 50%。

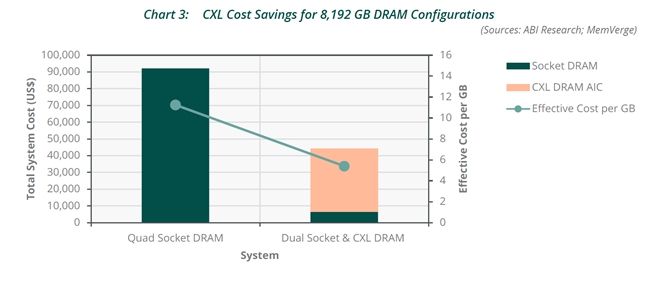

市场调研机构 ABI Research 在一份报告中介绍,CXL 技术通过内存池化和共享内存资源,显著提高了内存利用率。例如,与传统方案相比,CXL 内存扩展可以将每 GB 内存的成本降低约 52%。采用 CXL 技术后,采用内存扩展的 CPU 的每 GB 内存成本将大幅降低。平均而言,将节省 55%。

内存成本节省是 CXL 技术的主要需求驱动因素之一,总体性能的提升也是各大厂商积极部署 CXL 的重要因素。在数据中心领域,CXL 技术通过统一内存地址空间和减少通信延迟,显著提升了系统性能。例如,SK 海力士与数据处理平台企业 HazelCast 的实证结果显示,采用 CXL 内存后,系统处理速率提升了 40%,超越仅使用 DRAM 的系统;同时,延迟时间减少了 30-50%。这表明,使用 CXL 内存可以有效节省高昂的 DRAM 成本。

三、应用场景:从云到端,CXL落地加速

1. 云计算与数据中心

(1)AI训练集群:通过 CXL 内存共享,可减少千亿参数模型的训练节点数量,以及通信开销。这对于大规模深度学习模型的训练具有重要意义,能够大幅缩短训练时间并降低运营成本。

(2)混合负载整合:同一服务器同时运行 AI 推理、数据库与虚拟化任务,可以提升资源利用率。这种灵活的任务调度方式提高了服务器的整体效能,使其能够在不同的工作负载之间实现无缝切换。

2. 边缘计算与终端设备

(1)智能汽车:CXL 实现 CPU、NPU 等处理器的内存统一管理,满足自动驾驶低延迟需求。在复杂的交通环境中,毫秒级的响应速度至关重要,CXL 技术可以帮助车辆更快地做出决策。

(2)AR/VR设备:通过 CXL 互联的定制化 SoC,在有限功耗下支持 4K 实时渲染与 AI 交互。这对于沉浸式体验的增强现实和虚拟现实应用来说,意味着更流畅的用户体验和更高的视觉质量。

3. 存算一体新范式

CXL 与存算一体芯片(如存内计算 DRAM)结合,可构建「内存即算力」架构,解决传统冯·诺依曼瓶颈,潜力市场达百亿美元。

四、市场空间与产业链投资图谱

1. 市场规模预测

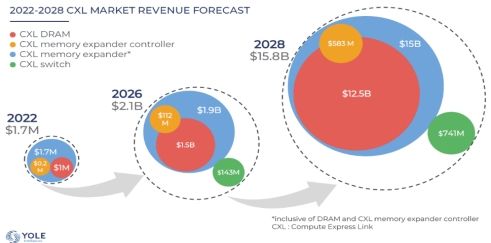

据市场咨询机构 Yole 预测,到 2028 年,CXL 市场新增规模将达到近 160 亿美元。中国市场规模预计将占 1/2,达 80 亿美元。

值得一提的是,除了存储扩展,CXL 3.0 版本引入的 CXL Switch 将支持多层级联,使其在功能和适用场景上超越了传统 PCIe Switch,完美适配 AI 集群的扩展。

(1) CXL Switch 新增市场

Yole 预测,到 2028 年,CXL Switch 新增市场规模将达到 7.41 亿美元。中国市场规模预计将占 1/2,达 3.705 亿美元。

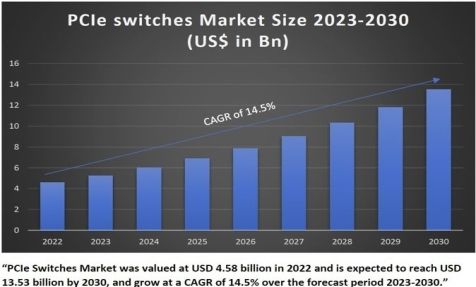

(2) CXL Switch 存量替换市场

结合 SNS Insider、Transparency 等市场机构数据,全球 PCIe 交换芯片市场规模预计将从 2022 年的 45.8 亿美元增长到 2028 年的 104.3 亿美元。中国市场约占 PCIe 交换芯片市场规模的 1/2,预计 2028 年市场规模将达 52.15 亿美元。

保守估计,未来有 50% 以上的 PCIe Switch 都会逐步切换到 CXL Switch 上,到 2028 年全球 CXL Switch 存量替代市场规模将达 52.15 亿美元,其中中国该市场规模将达 26.08 亿美元。

结合存量市场及新增市场,预计到 2028 年,CXL Switch 市场全球将达到 59.56 亿美元,其中中国将占 29.79 亿美元市场。

2. CXL相关上市公司(二级市场):

(1)核心芯片及模组厂商:Intel、AMD、Broadcom、Marvell、Astera Labs、澜起科技(CXL 内存接口芯片)、江波龙、佰维存储

(2)IP 厂商:Synopsis、Rambus

(3)存储巨头:Samsung、Micron、SK Hynix

(4)服务器厂商:浪潮、新华三、联想

(5)云计算巨头:亚马逊 AWS、微软 Azure、阿里等云计算厂商大力投入,希望通过技术创新来保持其在云计算市场的领先地位。

五、结论:CXL——开启算力普惠时代的钥匙

在 AI 从「技术炫技」转向「商业落地」的临界点,CXL 通过硬件资源解耦与异构效率革命,直击行业痛点,未来 3-5 年将渗透至算力基础设施全场景。建议投资者把握 CXL 3.X 标准落地与 AI 服务器升级周期,建议优先布局核心芯片、存储扩展与生态龙头,关注初创企业,分享千亿级市场红利。

通过对 CXL 技术的深入理解与前瞻布局,投资者不仅可以抓住当前的技术变革机遇,还能为未来的持续增长奠定坚实基础。CXL 作为新一代计算架构的核心组件,有望引领新一轮的技术革命,助力各行各业实现智能化转型。